Crawler

Un crawler ou robot d'exploration est un programme informatique qui recherche automatiquement des documents sur le web. Les crawlers sont initialement programmés pour effectuer des actions répétitives, afin que la navigation soit entièrement automatisée. Les moteurs de recherche utilisent des crawlers le plus souvent afin de naviguer sur la toile et de construire un index. D’autres crawlers recherchent en revanche différents types d’informations (flux RSS, adresses e-mail, etc.). Le terme de crawler provient du nom du tout premier moteur de recherche sur Internet : le Web Crawler. Aujourd'hui, les termes courants sont également araignées web, crawlers web, araignées, robots de recherche, robots de moteurs de recherche ou tout simplement bot. Le crawler web le plus populaire est leGooglebot.

Comment ça marche

En principe, un crawler est comme un documentaliste. Il recherche les informations sur le Web, qu’il assigne ensuite à certaines catégories, puis il les indexe et en fait l’inventaire : les informations indexées sont ainsi récupérables et peuvent être examinées. Alors que le documentaliste travaille de façon autosuffisante et assignent des tâches à son équipe, le crawler est différent car il n’est pas indépendant.

Les opérations du programme informatique ont besoin d’être mises en place avant que le crawler ne commence. Chaque commande est définie à l’avance. Le crawler exécute les instructions automatiquement. Une indexation est créée avec les résultats émis par le crawler. Elle est accessible grâce aux données de sortie du logiciel.

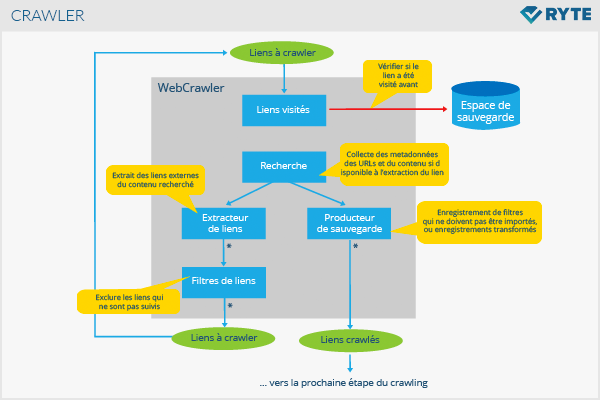

Le type d’informations rassemblées sur la toile par le crawler dépend d’instructions particulières. Les graphiques suivant visualisent le lien de relations qui a été découvert par un crawler.

Applications

Le but initial d’un crawler est de créer un index. Les crawlers sont donc la base pour le travail de chaque moteur de recherche. Ils ratissent dans un premier temps la toile à la recherche de contenus et rendent les résultats disponibles pour les utilisateurs. Les crawlers ciblés se concentrent par exemple sur le contenu actuel et pertinent des sites web au moment de l’indexation.

Mais les crawlers web sont aussi utilisés au sein d’autres disciplines :

- Portails de comparaison de prix qui recherchent des informations sur un produit spécifique, afin que les prix ou les données puissent être comparées en temps réel.

- Dans le domaine du datamining, un crawler peut collecter des adresses e-mail ou postales des entreprises qui sont publiques.

- Les outils d’analyse du web utilisent les crawlers ou les robots pour collecter les données sur les vues de pages, les liens entrants ou les liens de rebond.

- Les crawlers servent à créer des centres d’informations de données, comme par exemples de nouveaux sites web.

Crawler vs Scraper

Au contraire d’un scraper, un crawler collecte uniquement les données et les prépare. Le scraping est une technique du black hat qui vise à copier les données relatives au contenu d’autres sites et à les placer à peine modifiées sur son propre site web. Alors que le crawler travaille principalement avec des metadonnées qui ne sont pas visibles au premier regard pour l’utilisateur, le scraper extrait un contenu tangible.

Bloquer un crawler

Si vous ne voulez pas que certains crawlers explorent votre site, vous pouvez exclure leur agents utilisateurs en utilisant un robots.txt. Mais cela ne peut pas empêcher le contenu de se voir indexé par les moteurs de recherche. Le metatag noindex ou la balise canonique sont donc mieux appropriés à ce propos.

Importance pour le référencement

Les robots de recherche comme le Googlebot créent les conditions préalables pour que les pages web soient classées dans les SERP en explorant et en indexant. Ils suivent des liens permanents sur la toile et sur les sites web. Chaque crawler n'a qu'une période de temps limitée par page, notamment en raison du budget d'exploration (ou crawl budget). En optimisant la structure du site, la navigation et des aspects techniques comme la taille du fichier, les exploitants de sites web peuvent mieux exploiter le budget de recherche du robot. Dans le même temps, le budget se voit augmenter par un grand nombre de liens entrants et une haute fréquentation du site web. Cependant, le fichier robots. txt et le sitemap XML stocké dans Google Search Console sont des outils importants pour contrôler les robots comme le Googlebot. En outre, Google Search Console peut être utilisée pour vérifier si toutes les zones pertinentes d'un site web peuvent être consultées et indexées par le Googlebot.

Liens web

- Définition : crawler moteur, definitions-marketing.com, ouvert le 29.08.2017

- Spiders, Robots, Crawlers : comment ça marche ?, abondance.com, ouvert le 29.08.2017

- Robot d’indexation : crawler, bot et spider, 1min30.com, ouvert le 29.08.2017