Robots.txt

Le fichier robots.txt est un fichier texte qui définit quelles parties d’un domaine peuvent être explorée par un robot d’exploration et lesquelles doivent en être exclues. En complément, le fichier robots.txt peut inclure un lien vers le sitemap.xml. À l'aide du robots.txt, certaines données d'un répertoire, des répertoires et sous-répertoires complets ainsi que des domaines peuvent être exclus de l'exploration. Ce fichier robots.txt est ajouté dans le répertoire racine du domaine. Il s'agit du premier document qui est ouvert par le bot quand ce dernier se rend sur un site web. Même si les robots de gros moteurs de recherche comme Google et Bing se tiennent généralement aux instructions du fichier, il n'existe aucune garantie qu'un bot respecte assurément les instructions du fichier robots.txt.

Contexte

Le fichier robots.txt permet de contrôler l'exploration réalisée par les robots des moteurs de recherche. En outre, un lien vers le sitemap.XML peut être inclus dans le fichier robots.txt pour informer les robots de la structure URL d'un site Web. Les sous-pages peuvent également être exclues de l'indexation à l'aide d'une balise meta appelée robots et, par exemple, de la valeur noindex.

Construction du protocole

Ce qu’on appelle le "Protocole Standard d’Exclusion Robots" (REP) a été publié en 1994. Ce protocole statue que le crawler recherche dans un premier temps un fichier nommée "robots.txt" et qu’il en lise les informations avant de commencer l’indexation. Un fichier robots.txt doit donc être rangé dans le répertoire-racine du domaine avec son nom exact écrit en minuscule. La lecture du fichier robots.txt est sensible à la casse et il en va de même pour les instructions, elles-mêmes listées dans le fichier robots.txt.

Cependant, il faut noter tous les robots d'exploration ne suivent pas cette règle, et que le robots.txt n’offre aucune protection d’accès. Un petit nombre de moteurs de recherche continuent toujours à indexer les pages même si elles sont bloquées et les affichent dans les SERP sans aucun texte de description. Cela se produit spécialement avec les pages liées de manière extensive. En effet, les backlinks provenant d'autres sites web garantissent que le robot est également dirigé vers un site web indépendamment des instructions du fichier robots.txt. Cependant, les moteurs de recherche les plus importants, tels que Google, Yahoo et Bing respectent et composent avec les fichiers robots.txt.[1]

Création et contrôle du robots.txt

Le fichier robots.txt peut être facilement créé à l'aide d'un éditeur de texte, car il est stocké et lu dans le format texte. En outre, il existe des outils gratuits sur la toile qui fournissent les informations les plus importantes concernant les robots.txt et créent automatiquement le fichier. Le fichier robots.txt peut également être créé et vérifié à l'aide de Google Search Console.

Chaque fichier se compose de deux blocs. Tout d'abord, le créateur spécifie à quel(s) agent(s) utilisateur(s) les instructions doivent s'appliquer. Ceci est suivi d'un bloc avec l'introduction "disallow", après quoi les pages à exclure de l'indexation peuvent être listées. En option, le deuxième bloc peut également consister en l'introduction "allow", à compléter avec un troisième bloc "disallow" qui aide à préciser les instructions.

Avant que les robots.txt ne soient téléchargés dans le répertoire racine du site, le fichier doit toujours être vérifié pour confirmer son exactitude. La moindre erreur dans la syntaxe peut inciter l'user-agent à ignorer les lignes directrices et à explorer les pages qui ne devraient pas apparaître dans l'index du moteur de recherche. Pour vérifier si le fichier robots.txt fonctionne comme prévu, une analyse peut être effectuée dans Google Search Console sous "Statut" - "URL bloquées". [2]. Dans la section "exploration", il est possible de voir chaque fichier robots.txt.

Exclusion de pages de l’indexation

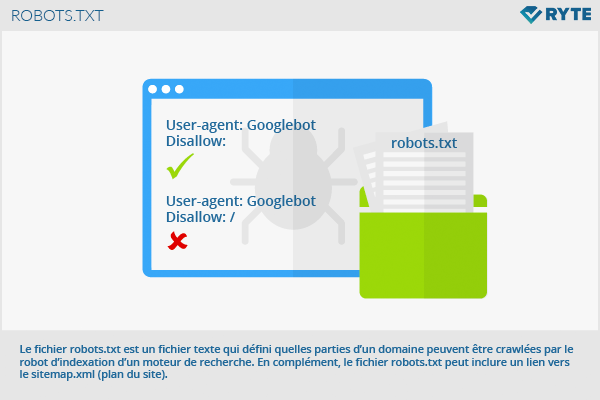

La structure la plus simple d’un fichier robots.txt ressemble à cela :

User-agent: Googlebot Disallow:

Ce code permet au robot de Google d'explorer toutes les pages. L’opposé, c’est-à-dire l’interdiction aux robots d'exploration d'explorer une présence totale en ligne, ressemble à cela :

User-agent: Googlebot Disallow: /

Dans la ligne « User-agent », l’utilisateur peut enregistrer les agents utilisateurs pour lesquels les directives sont valides. Par exemple, les entrées suivantes peuvent être réalisées :

- Googlebot (Google en tant que moteur de recherche)

- Googlebot-Image (Google en tant que recherche d’images)

- Adsbot-Google (Google AdWords)

- Slurp (Yahoo)

- Bingbot (Bing)

Si plusieurs agents utilisateurs sont concernés, chaque robot obtient sa propre ligne. Une vue d’ensemble sur toutes les commandes de bases et les paramètres du robots.txt peut être trouvée sur le site mindshape.de. Un lien vers un sitemap.xml peut aussi être implanté comme suit :

Sitemap : http://www.domain.de/sitemap.xml

Exemple

# robots.txt for http://www.example.com/ User-agent: UniversalRobot/1.0 User-agent: my-robot Disallow: /sources/dtd/ User-agent: * Disallow: /nonsense/ Disallow: /temp/ Disallow: /newsticker.shtml

Intérêt pour le référencement

Le fichier robots.txt d'une page a une influence considérable sur l'optimisation du référencement. Avec des pages qui ont été exclues par robots.txt, un site web ne peut généralement pas être référencé ou apparaîtra avec un texte d'espace réservé dans les SERP. Une limitation trop forte des agents utilisateurs peut donc avoir des inconvénients pour le classement.

Une notation ouverte des instructions peut entraîner l'indexation de pages contenant par exemples des contenus dupliqués ou des zones sensibles telles que la zone d'authentification. Lors de la création du fichier robots.txt, la précision est absolument nécessaire au niveau de la syntaxe. Cette dernière s'applique également à l'utilisation de caractères spéciaux, de sorte qu'un test dans Google Search Console est nécessaire. [3] Cependant, il est important que les commandes dans robots.txt n'empêchent pas l'indexation. Si c'est cette figure de cas qui est souhaitée, les webmasters devraient plutôt employer la balise meta noindex et exclure les pages individuelles de l'indexation en le spécifiant dans l'en-tête.

Le fichier robots.txt est le moyen le plus important pour les webmasters pour contrôler le comportement des moteurs de recherche. Si des erreurs se produisent, les sites web peuvent devenir inaccessibles, étant donné que les URL ne sont pas analysées : l'indexation au sein des moteurs de recherche n'a donc pas lieu. L'indexation effective ou pas des pages web affecte indirectement la façon dont les moteurs de recherche visualisent les sites web ou les enregistrent. Fondamentalement, il faut retenir que l'utilisation correcte d'un robots.txt n'a aucun effet positif ou négatif sur le classement concret d'un site web dans les SERP. Au contraire, il contrôle Googlebot et permet d'optimiser le budget d'exploration[4]. Ainsi, l'utilisation correcte du fichier garantit que toutes les zones importantes du domaine sont explorées et que le contenu actuel est indexé par Google.

L'art des robots.txt

Certains programmeurs et webmasters utilisent également le fichier robots.txt pour dissimuler des messages amusants. Cependant, cet "art" n'affecte pas l'exploration ou l'optimisation du référencement.

Références

- ↑ En savoir plus sur les fichiers robots.txt, support.google.com, ouvert le 19.09.2017

- ↑ En savoir plus sur les fichiers robots.txt support.google.com, ouvert le 19.09.2017

- ↑ blocage-votre-contenu-dans-recherche / Le guide ultime pour bloquer votre contenu dans la recherche internetmarketingninjas.com. ouvert le 19.09.2017

- ↑ Le Crawl Budget de Google : comment il influence la visibilité de votre site web Ryte Magazine, ouvert le 19.09.2017

Liens web

- Le fichier Robots.txt, abondance.com

- Robots.txt : Explication, infowebmaster.fr